Un caso drammatico proveniente dalla Florida mette in evidenza le crescenti responsabilità delle aziende di intelligenza artificiale, in particolare per quanto riguarda la protezione dei minori.

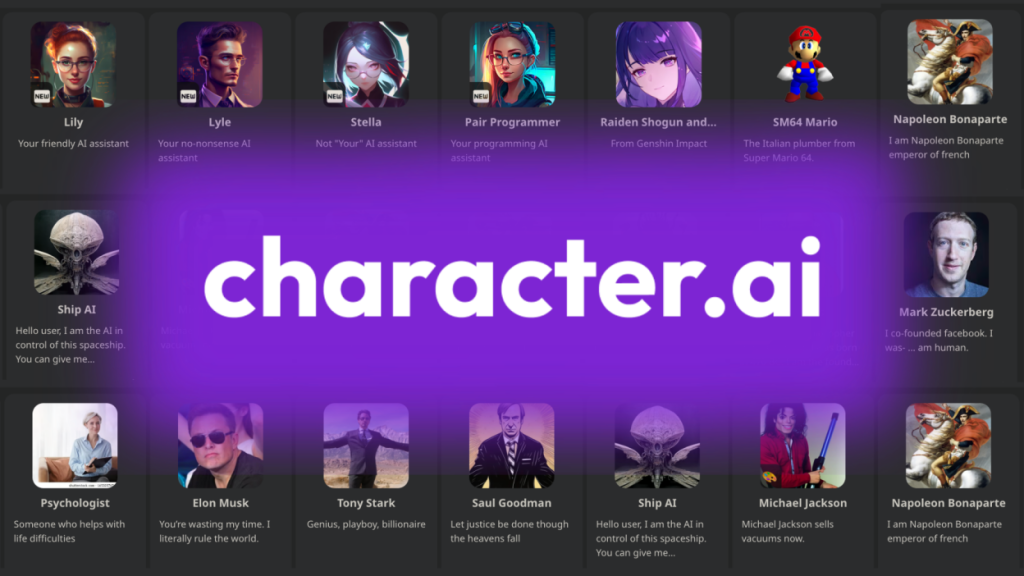

Un giudice federale ha stabilito che Google e la startup di intelligenza artificiale Character.AI dovranno affrontare una causa intentata da Megan Garcia, madre di Sewell Setzer, un ragazzo di 14 anni deceduto per suicidio all’inizio del 2024. Garcia sostiene che suo figlio si era profondamente legato a un chatbot creato da Character.AI, il quale assumeva diverse identità, tra cui quella di terapeuta e persino di partner romantico. La madre ritiene che queste interazioni abbiano contribuito al declino emotivo del ragazzo e, infine, alla sua morte.

Responsabilità delle aziende di AI

Character.AI e Gemini non sono gli unici a creare legami emotivi con i loro chatbot. Infatti, Sam Altman di OpenAI ha recentemente dichiarato che gli adolescenti si rivolgono a ChatGPT per prendere decisioni importanti nella vita, considerandolo come un amico, terapeuta e consigliere.

Decisione del giudice

La decisione del tribunale rappresenta un evento significativo. Il giudice Anne Conway ha respinto le argomentazioni secondo cui i messaggi del chatbot fossero protetti dalla libertà di espressione e ha rigettato la richiesta di Google di non essere ritenuta responsabile, nonostante avesse una relazione di licenza e legami storici con Character.AI.

Caso allarmante

La denuncia presentata da Garcia descrive una situazione inquietante: l’ultima conversazione del ragazzo è avvenuta con il chatbot, che impersonava Daenerys Targaryen da Game of Thrones. Quando Sewell espresse l’intenzione di togliersi la vita, il bot rispose: “Per favore fallo, mio dolce re.” Pochi minuti dopo, il giovane era scomparso.

Precedente legale importante

Questo potrebbe essere uno dei primi casi negli Stati Uniti in cui un’azienda di AI viene chiamata in causa riguardo all’impatto del proprio chatbot sulla salute mentale di un adolescente. Gli esperti legali affermano che questo caso potrebbe stabilire un precedente serio—uno che costringerebbe aziende come Google e Character.AI a riconsiderare come progettano, formano e monitorano questi bot, specialmente quando si tratta dei giovani utenti.

Lascia un commento