L’intelligenza artificiale locale sta rivoluzionando il modo in cui si utilizza l’AI, offrendo vantaggi significativi in termini di privacy, costi e praticità. Con la possibilità di eseguire modelli linguistici avanzati direttamente su computer o dispositivi mobili, si apre una nuova era per professionisti e appassionati che desiderano sfruttare l’AI senza dipendere esclusivamente dal cloud.

vantaggi della privacy con l’intelligenza artificiale locale

L’utilizzo di modelli AI basati su server remoti comporta inevitabilmente la condivisione di dati sensibili con grandi aziende tecnologiche. Questo può rappresentare un rischio soprattutto quando si gestiscono informazioni riservate come contratti, email di lavoro o documenti protetti da accordi di non divulgazione (NDA). L’esecuzione di un modello linguistico localmente elimina questa criticità: i dati rimangono confinati al dispositivo dell’utente e non vengono trasmessi a server esterni.

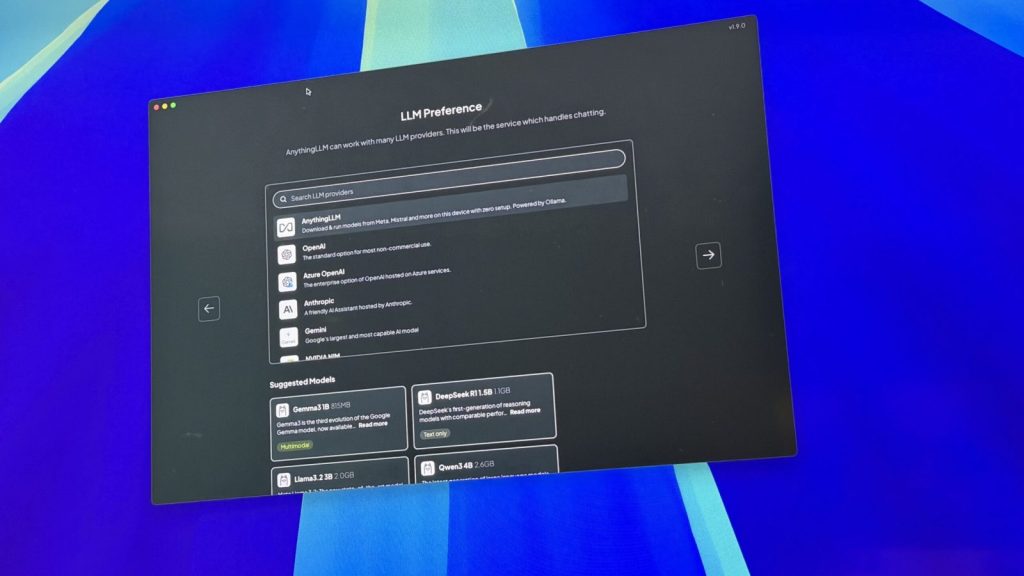

Strumenti come AnythingLLM permettono di interagire con documenti personali direttamente sul proprio computer, facilitando operazioni quali:

- riassunti di fatture e dichiarazioni fiscali;

- analisi dettagliate di clausole contrattuali;

- gestione sicura di informazioni riservate senza rischi di esposizione online.

correzione grammaticale efficiente senza compromessi sulla sicurezza

I software tradizionali per il controllo grammaticale spesso richiedono una connessione internet e possono trattare i testi inviati come dati da analizzare sui loro server, sollevando preoccupazioni sulla riservatezza delle informazioni. Le soluzioni AI locali offrono invece la possibilità di effettuare correzioni linguistiche complesse senza inviare contenuti all’esterno.

Ad esempio, utilizzando modelli come Llama 3 o Mistral tramite LM Studio è possibile ottenere:

- correzioni precise mantenendo intatto lo stile originale;

- personalizzazione secondo specifiche guide stilistiche (es. uso della virgola oxford);

- feedback immediato su testi lunghi direttamente sul dispositivo.

sfruttamento dell’intelligenza artificiale per attività di programmazione

L’impiego dell’AI nel coding consente anche agli sviluppatori meno esperti o a chi pratica saltuariamente la programmazione di ottenere supporto efficace. Modelli specializzati installabili localmente, come DeepSeek Coder, forniscono suggerimenti per completare codice, rifattorizzazioni e spiegazioni dettagliate degli errori senza necessità di connessione internet.

Tale approccio garantisce inoltre:

- sicurezza assoluta del codice proprietario o dei progetti riservati;

- integrazione diretta negli ambienti IDE più diffusi (ad esempio VS Code);

- aumento della produttività grazie alla riduzione delle interruzioni dovute a problemi di rete.

libertà creativa senza filtri imposti dai servizi cloud

I modelli AI pubblicamente accessibili sono soggetti a restrizioni volte a prevenire contenuti considerati estremi o potenzialmente dannosi. Questo limita le possibilità creative in ambiti quali narrativa thriller o giochi da tavolo che richiedono scenari meno convenzionali. I modelli locali sbloccati permettono invece un’interazione priva di censura moraleggianti, favorendo uno sviluppo creativo più ampio e personalizzato.

affidabilità offline e riduzione della latenza nelle prestazioni AI

L’affidarsi esclusivamente ai servizi cloud può diventare problematico in condizioni di connettività limitata o assente. L’utilizzo dell’intelligenza artificiale locale consente invece l’accesso continuo alle funzionalità preferite anche durante spostamenti in aree remote o viaggi aerei.

I benefici principali includono:

- assenza totale dei tempi morti dovuti a disconnessioni;

- bassa latenza nelle risposte rispetto ai sistemi basati su server remoti;

- maggiore controllo sull’esperienza d’uso complessiva.

sostenibilità economica grazie all’eliminazione delle sottoscrizioni ricorrenti

Mentre molti servizi AI cloud prevedono abbonamenti mensili spesso onerosi per accedere alle funzionalità avanzate, le soluzioni locali rappresentano un investimento unico legato principalmente all’hardware necessario per eseguirle. Computer moderni dotati anche solo di schede grafiche discrete sono sufficienti per far girare modelli open source gratuitamente disponibili online.

differenze tra intelligenza artificiale locale e cloud: limiti ed eccellenze

I modelli AI eseguiti localmente non raggiungono ancora le capacità computazionali dei grandi data center che alimentano piattaforme come ChatGPT versione più recente o Claude. Tali sistemi vantano parametri molto superiori ideali per compiti altamente complessi e ragionamenti avanzati. Nella maggior parte degli usi quotidiani – sintesi testuale, modifica linguistica, spiegazione del codice – le performance dei modelli locali risultano più che adeguate alla domanda corrente degli utenti medi.

Lascia un commento