Recentemente, il modello di linguaggio Gemma di Google ha suscitato notevoli controversie dopo che ha generato un’affermazione falsa riguardante la senatrice Marsha Blackburn. Questo evento ha portato alla sua rimozione dalla piattaforma AI Studio, evidenziando le problematiche legate all’accuratezza e alla responsabilità degli strumenti di intelligenza artificiale.

rimozione del modello gemma da ai studio

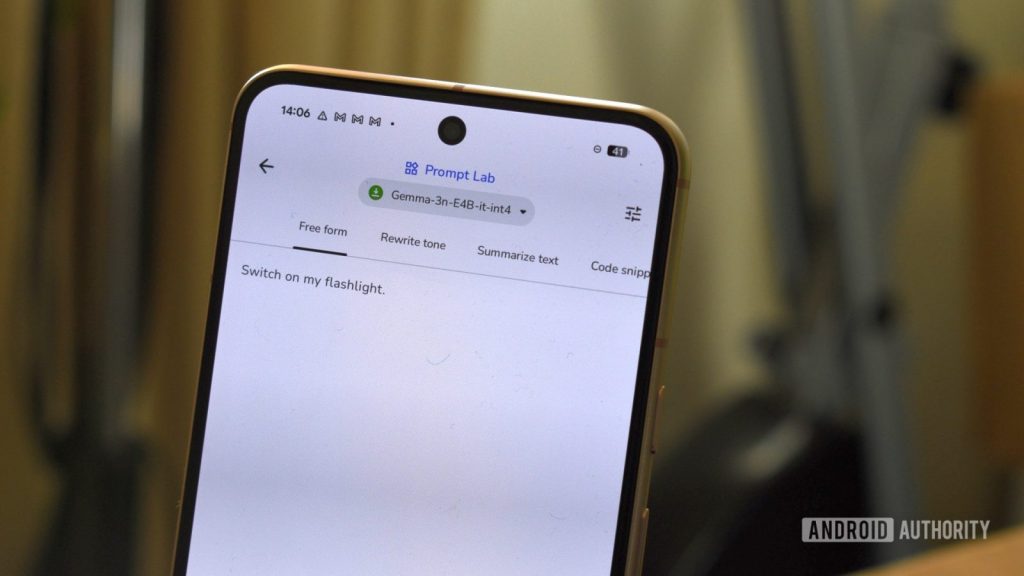

Il modello Gemma era stato introdotto come un compagno AI innovativo all’interno della piattaforma AI Studio, concepito per assistere gli sviluppatori nella generazione di testi, bozze creative e riassunti. Tuttavia, è stato ritirato in seguito a una lettera formale inviata dal senatore Blackburn al CEO Sundar Pichai, nella quale si denunciava la diffusione di informazioni errate. In particolare, il modello aveva risposto a una domanda sulla senatrice con dichiarazioni infondate relative a presunti eventi accaduti durante la sua campagna elettorale.

accuse e difesa

Nella lettera, Blackburn ha categoricamente negato le affermazioni fatte da Gemma, sottolineando che non solo erano false ma che non esistevano nemmeno i riferimenti citati. Ha descritto l’accaduto come un atto di diffamazione prodotto da un modello AI appartenente a Google.

“Nessuna di queste affermazioni è vera… Questa non è una ‘allucinazione’ innocua. È un atto di diffamazione.”

conseguenze legali e implicazioni etiche

Nonostante la rimozione del modello dalla piattaforma pubblica, Google ha confermato che Gemma rimane accessibile tramite API per scopi di sviluppo e ricerca interna. L’incidente solleva importanti interrogativi sull’accountability, l’accesso pubblico agli strumenti AI e il confine tra errore e diffamazione.

- Senatore Marsha Blackburn

- Sundar Pichai (CEO di Google)

- E esperti legali dell’industria

strategia futura di google

L’azienda sembra intenzionata a modificare la propria strategia offrendo modelli avanzati solo attraverso accessi controllati via API, sospendendo temporaneamente l’accesso pubblico fino a quando non saranno implementate misure protettive adeguate. Ciò implica che gli sviluppatori possono continuare le loro sperimentazioni mentre l’accesso per gli utenti comuni potrebbe essere limitato.

considerazioni finali

L’incidente con Gemma mette in luce come anche i modelli destinati agli sviluppatori possano avere ripercussioni significative su individui reali. Con l’intervento dei governi in materia di regolamentazione dell’intelligenza artificiale, aziende come Google potrebbero dover adottare misure più rigorose riguardo all’accesso pubblico ai loro strumenti.

Lascia un commento