Recentemente, Meta ha risolto una significativa vulnerabilità di sicurezza nel suo chatbot Meta AI. Questo difetto consentiva agli utenti di accedere a richieste private e risposte generate dall’intelligenza artificiale di altri utenti.

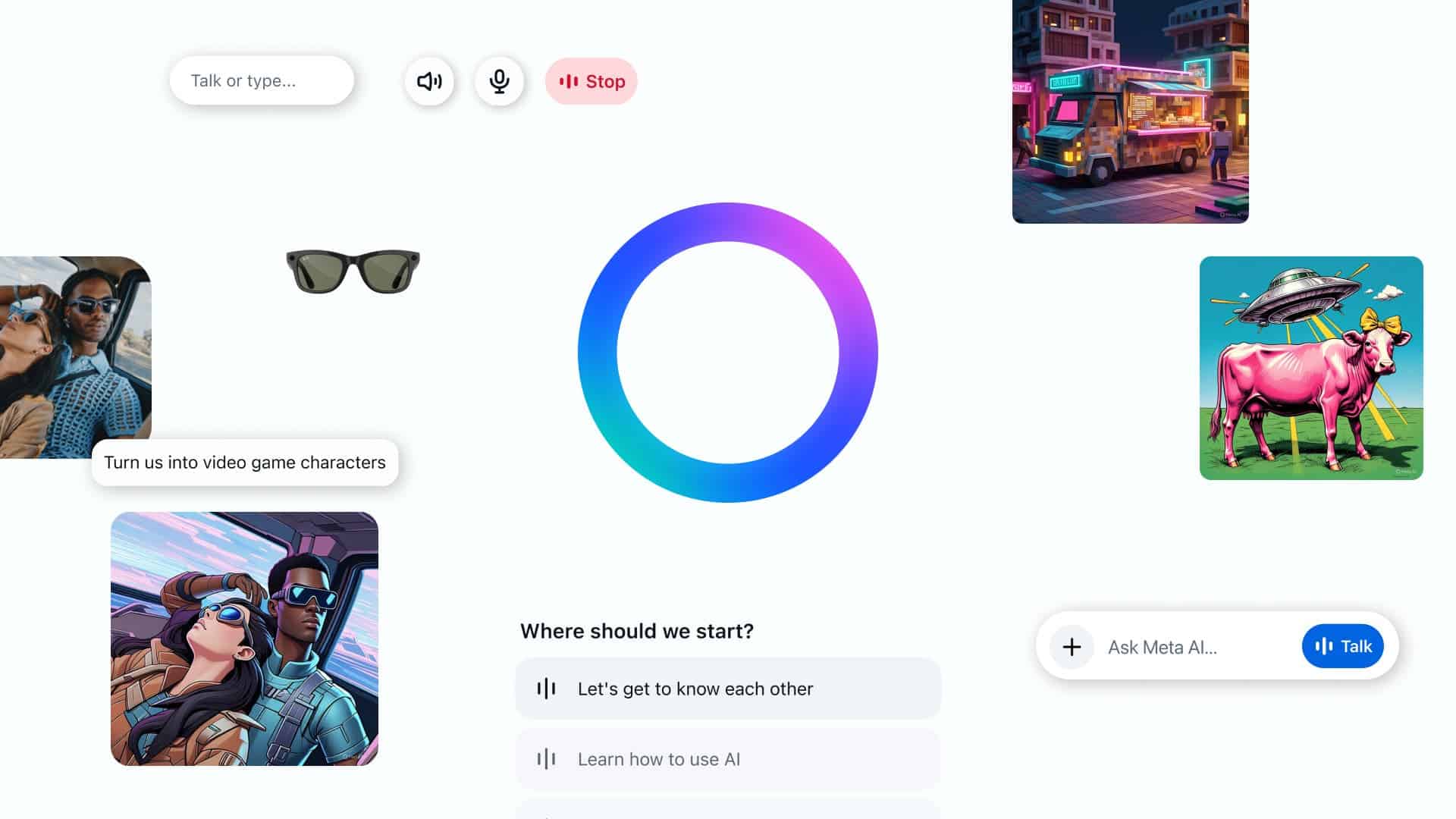

Meta risolve il bug di sicurezza che esponeva le conversazioni private di Meta AI

Sandeep Hodkasia, fondatore della società di cybersecurity AppSecure, ha scoperto la falla. Dopo averla segnalata a Meta il 26 dicembre 2024, ha ricevuto un premio di 10.000 dollari per la segnalazione privata. Il problema è stato corretto quasi un mese dopo, il 24 gennaio 2025.

Secondo quanto riportato da Hodkasia, il bug riguardava la gestione dell’editing delle richieste da parte di Meta AI. Gli utenti autenticati possono modificare le richieste precedenti per generare nuovi testi o immagini. Quando una richiesta viene modificata, i server di Meta assegnano un numero ID unico ad essa. Analizzando l’attività della rete del suo browser, Hodkasia ha scoperto che era possibile cambiare questo ID, permettendo così l’accesso a richieste e risposte altrui senza autorizzazione.

Violazione della privacy in Meta AI rivelata dal ricercatore

L’origine del problema era un controllo degli accessi inadeguato. I server di Meta non riuscivano a confermare se un utente fosse autorizzato a visualizzare una specifica richiesta. Hodkasia ha evidenziato come i numeri ID fossero semplici e prevedibili, rendendo possibile indovinarli o utilizzare strumenti automatizzati per accedere ai dati altrui.

Meta ha confermato che il bug è stato risolto a gennaio. Un portavoce dell’azienda, Ryan Daniels, ha dichiarato a TechCrunch: “Non abbiamo trovato prove di abusi e abbiamo premiato il ricercatore.”

Sebbene nessuno abbia sfruttato questa vulnerabilità nel mondo reale, essa mette in luce i rischi associati allo sviluppo rapido dell’intelligenza artificiale. Le aziende tecnologiche sono impegnate in una corsa per lanciare strumenti AI ma molte continuano a trascurare problemi seri legati alla privacy e alla sicurezza.

L’app Meta AI, lanciata all’inizio dell’anno per competere con strumenti popolari come ChatGPT, ha già affrontato problematiche sin dall’inizio; alcuni utenti hanno accidentalmente reso pubbliche le loro chat private. Ora questo difetto solleva ulteriori preoccupazioni sulla capacità della piattaforma di proteggere i dati degli utenti.

Gli esperti di sicurezza affermano che incidenti come questo sottolineano la necessità di test rigorosi prima del rilascio degli strumenti AI. La scoperta effettuata da Hodkasia dimostra come errori banali nel codice possano esporre informazioni sensibili.

Anche se Meta ha reagito rapidamente in questo caso, è fondamentale mantenere una vigilanza costante. Con la crescente diffusione delle app AI, il costo delle violazioni della sicurezza potrebbe aumentare notevolmente.

Lascia un commento